Com base em um projeto liderado por engenheiros da Microsoft, a fabricante de chips Quantinuum desenvolveu um processador quântico que representa um avanço significativo na resolução de um dos principais desafios para a construção de computador quântico mais poderoso: a correção de erros.

As propriedades quânticas que viabilizam o funcionamento desses computadores são altamente sensíveis, resultando na fácil perda de dados pelos qubits. Essa fragilidade leva a uma ocorrência frequente de erros, prejudicando a tão almejada supremacia quântica.

Embora existam projetos de qubits de luz com correção de erros integrada, as duas empresas optaram por utilizar o conceito de qubits lógicos, que consiste em grupos de qubits físicos interligados por meio de entrelaçamento quântico. Esse sistema, que compartilha o mesmo dado entre muitas unidades físicas, confere uma capacidade de correção de erros.

A parceria entre as duas empresas alcançou um progresso significativo quando a equipe da Microsoft conseguiu aprimorar seus avanços na correção de erros, reduzindo em 10 vezes uma estimativa inicial de 300 qubits físicos necessários para criar quatro qubits lógicos, o mínimo para realizar tarefas de teste válidas. Ao projetar quatro qubits lógicos com apenas 30 qubits físicos, a técnica tornou-se viável para o processador quântico H2 da Quantinuum, que possui 32 qubits.

No fim do ano passado, um grupo composto por pesquisadores da Universidade de Harvard e da startup QuEra revelou um processador quântico resistente a falhas, equipado com 48 qubits lógicos – um avanço que representa uma capacidade 12 vezes maior do que a demonstrada neste contexto.

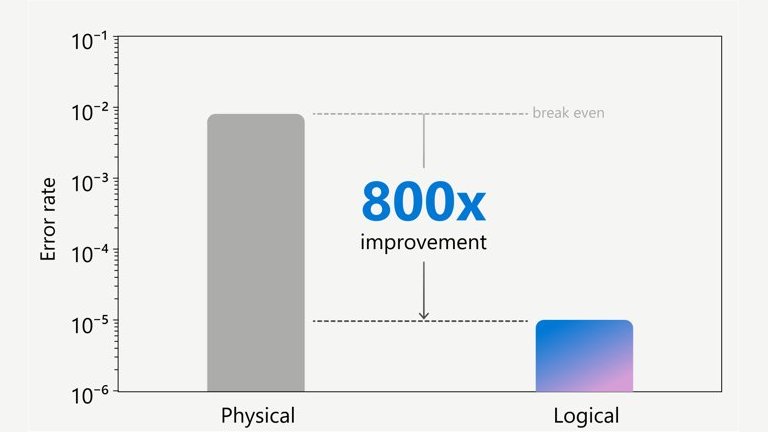

O grande destaque aqui é que a equipe conseguiu operar com um qubit a menos por qubit lógico, resultando em uma taxa de erros ainda mais baixa, alcançando o que foi denominado pela equipe da Microsoft como “Fase 2 de Resiliência”, um feito inédito até então.

Durante esta primeira série de testes de virtualização de qubits, foram executadas 14.000 rotinas de algoritmos quânticos sem erros, um resultado global sem precedentes. Além disso, os testes serviram para demonstrar múltiplas iterações de “extração de síndrome ativa”, uma função essencial de correção de erros para detectar e mensurar erros sem comprometer a informação quântica armazenada no qubit lógico.

“A partir de 2025, planejamos lançar um novo computador quântico da série H, denominado Helios, que irá explorar ao máximo o potencial da série H, melhorando tanto a contagem física de qubits quanto a fidelidade física. Isso nos permitirá, bem como aos nossos usuários, ultrapassar o limiar para um conjunto mais amplo de códigos de correção de erros, tornando esse dispositivo capaz de suportar pelo menos 10 qubits lógicos altamente confiáveis,” anunciou a Quantinuum.

Na comunidade científica, é amplamente aceito que serão necessários pelo menos 100 qubits lógicos para viabilizar um computador quântico capaz de executar programas que solucionem problemas do mundo real.

Os componentes semicondutores utilizados na computação convencional também apresentam erros, no entanto, a tolerância a falhas é facilmente gerenciada: basta duplicar o valor de uma variável e armazená-la em outra célula de memória, criando redundância. Além disso, o desenvolvimento de transistores altamente robustos, com baixas taxas de erros, contribuiu significativamente para esse processo. No entanto, na computação quântica, não é viável replicar os dados dessa maneira e só recentemente começamos a produzir qubits.

Em termos teóricos, o desafio da correção de erros na computação quântica é bem compreendido e diversas abordagens têm sido exploradas. No entanto, os qubits atuais são extremamente sensíveis, exigindo o controle preciso dos estados quânticos de átomos individuais, o que os torna suscetíveis a erros. Além disso, a “lei da não clonagem” da física quântica impede a simples duplicação de qubits, o que significa que algumas técnicas de correção de erros utilizadas na computação clássica não são aplicáveis em máquinas quânticas.

Uma das soluções mais promissoras envolve a entrelaçamento de grupos de qubits físicos para formar um qubit lógico, armazenando assim as informações nesse estado entrelaçado e utilizando funções complexas para realizar cálculos com correção de erros. No entanto, a implementação dessas “funções complexas” requer um grande número de operações. Portanto, a fidelidade física de cada qubit deve ser suficientemente alta para que a implementação de um código de correção de erros não introduza mais ruído no circuito do que remove.

No entanto, quando a fidelidade física é alta o suficiente (ou seja, quando a taxa de erro físico está abaixo do limite), o código de correção de erros pode de fato reduzir os erros lógicos abaixo dos erros físicos, como foi alcançado pela equipe agora.

“O sucesso de hoje só foi possível graças ao uso do computador quântico H2 da Quantinuum, com sua incrível fidelidade de porta de dois qubits de 99,8%; os 32 qubits em nossa arquitetura QCCD; e conectividade de qubit todos para todos. Com base no desempenho excepcional de nossos sistemas atuais, continuaremos a inovar para tornar a computação quântica universal tolerante a falhas uma realidade mais próxima do que se imaginava,” afirmou Rajeeb Hazra, da Quantinuum.

Achou útil essa informação? Compartilhe com seus amigos!

Deixe-nos a sua opinião aqui nos comentários.